Nachdem ich in meinen letzten Artikeln den grundsätzlichen Aufbau eines SANs und das Verbinden eines Hyper-V Servers mit selbigem beschrieben habe, werde ich heute dafür sorgen, dass die Verbindung richtig performant wird. Ich habe daher mein SAN und meinen Hyper-V Server mit zwei Netzwerkkarten verbunden (in meinem Fall CrossOver – aber das ist nicht wirklich relevant). Ziel ist es nun meinen Windows 2008 R2 Server Core dazu zu bekommen beide Karten gleichzeitig dazu zu verwenden das SAN anzusprechen. Selbstverständlich muss das SAN das auch verstehen – das ist bei der von mir verwendeten Lösung “open-e” gegeben.

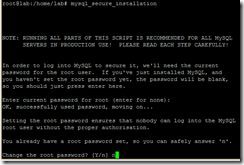

Zuerst müssen wir auf unserem Hyper-V Server das MPIO feature installieren. Das erledigt folgender Befehl:

ocsetup MultipathIO /norestart

(… wie der Name der Option /norestart vermuten lässt unterbinden wir im ersten Schritt einen Reboot – natürlich kann man den Server auch rebooten, das kommt aber eh gleich…)

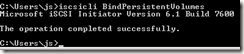

Nun sorgen wir dafür, dass alle Verbundenen LUNs auf MPIO umgestellt werden – man kann das auch über die ISCSICPL-Oberfläche erledigen, aber so gehts schneller 🙂

Vorsicht: Der Befehl fürht dazu, dass der Server ohne eine weitere Nachfrage neu startet.

mpclaim -r -i -d "MSFT2005iSCSIBusType_0x9"

Nach dem Neustart prüft man am besten kurz ob wirklich alle LUS’s auf MPIO umgestellt wurden:

mpclaim -s -d

In der vierten Spalte dieses Listings kann man zudem erkennen welche load balance Richtlinie aktiv ist. Das in meiner Aufstellung verwendete “RR” steht für Round Robin – in den meisten Fällen wird dies auch die beste Auswahl sein.

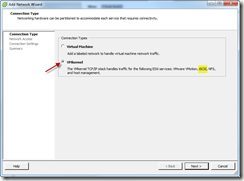

Nun wechseln wir auf die grafische Oberfläche der iSCSI – Konsole. Dies erreiche wir durch Eingabe des Befehls:

iSCSIcpl

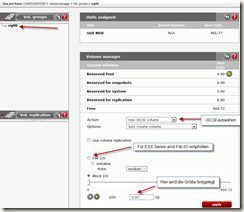

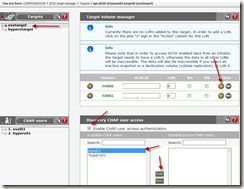

Um die MPIO Option für eine bestehende Verbindung zu konfigurieren, ist es notwendig, einen weiteren Pfad zu dem Device einzurichten. Hierzu wählt man das device aus und klickt auf “Connect”. Bei dem sich öffnenden Fenster muss die Option “Enable multi-path” aktiviert werden!

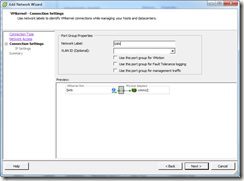

Über die Einstellungen unter “Advanced” kann man alternative Route auswählen und wenn nötig die Authentifizierung dafür einrichten:

Nachdem man die gemachten Eingaben bestätigt hat, kann man recht einfach prüfen ob alles wie gewünscht funktioniert hat:

mpclaim -s -d [Device#]

Mausfreunde können das ganze auch über iSCSIcpl prüfen:

That’ it. Unser Hyper-V ist jetzt über zwei Netzwerkverbindungen mit dem SAN verbunden. Selbstverständlich kann man die Schritte für jede weitere Netzwerkkarte analog durchführen und erhält somit immer mehr Durchsatz (Solange die Platten im SAN schnell genug sind ;-)).

Weiterführende Informationen:

Technet Seite mit der Befehlreferenz für MPCLAIM

Blog Post mit der Beschreibung wie man ein Windows 2008 R2 core an ein SAN anbindet