Ich habe mir vor einigen Wochen nun auch einen Raspberry Pi gekauft und war nun auf der Suche nach einem guten Einsatzort für den Kleinen. Da seit den letzten Veröffentlichungen von Edward Snowden wirklich jedem klar sein sollte, dass man public Clouds nicht trauen sollte, habe ich damit begonnen erneut OwnCloud zu testen.

OwnCloud ist ein auf PHP basierendes Open Source Projekt welches mit einfachen Mitteln eine private Cloud aufbaut und damit den Sync von Dateien, Kontakten, Musik etc. ermöglicht. Die Systemanforderungen sind dabei denkbar einfach. Man braucht an sich nur einen Apache Webserver unter Linux der das PHP Modul geladen hat.

Ein Rasberry Pi erfüllt die Systemvoraussetzungen für OwnCloud ohne Probleme und braucht gleichzeitig fast kein Strom (selbst bei Dauerbetrieb). Die Anschaffungskosten sind ebenfalls recht gering – man bekommt ein Gerät (ohne Festplatte) für unter 50 € z. B. bei amazon. Die Installation des Basis Betriebssystems ist ebenfalls denkbar einfach. Es gibt fertige Images die man einfach mit einem kleinen Tool auf die SD Karte überträgt und danach bootet. Ausführliche Anleitungen und verschiedene Distributionen findet man direkt auf den Projektseiten von RaspberryPi. In meinem Beispiel hier habe ich mir für Raspbian entschieden (ein Debian Port).

Installation des Apache

Den Apache Webserver installiert man unter Debian mit nur wenigen Befehlen:

sudo apt-get update sudo apt-get install apache2 php5

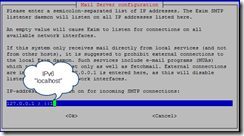

Nach der Installation läuft bereits ein normaler Webserver ohne SSL. Da wir eine sichere private Wolke haben wollen, aktivieren wir selbstverständlich auch SSL. Mit Nachfolgendem Befehl laden wir das notwendige Modul in unseren Webserver:

a2enmod ssl service apache2 restart

Das war es bereits, der Webserver spricht nun auch SSL allerdings mit einem selbst signierten Zertifikat welches ggf. nicht den externen DNS Namen enthält. Wie man dies ändert zeige ich in den nächsten Tagen.

Installation von OwnCloud

Man kann sich entweder den ownCloud Server Installer direkt von der OwnCloud Webseite herunter laden und diesen in /var/www/ ablegen und aufrufen oder man verwendet das vorhandene Debian Paket:

apt-get install owncloud

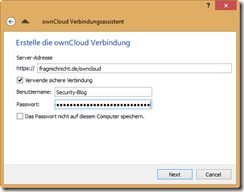

In beiden Fällen hat man nach wenigen Minuten seine eigene Cloud startklar und kann das Webfrontend über https://[IP oder DNS]/owncloud aufrufen.

Will man den Dienst auch vom Internet aus Benutzen, so ist es noch notwendig am Router eine Portweiterleitung einzurichten. Ich habe meinen PI in meine DMZ gestellt und einen high-port auf den SSL Port meines PI weiter geleitet. Damit wird man nicht alle paar Sekunden sondern nur alle paar Minuten gescannt…

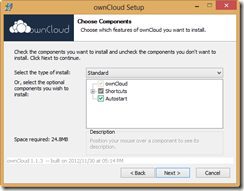

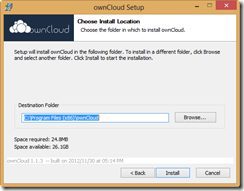

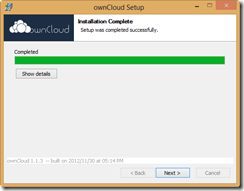

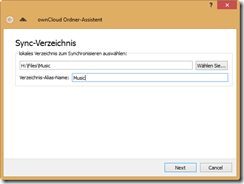

Clients

Neben einem Windows Client mit dem man einstellen kann, welche Dateien / Ordner gesynct werden sollen, gibt es auch noch einen iOS Client (kostet 0,89 €) bzw. einen Android Client.